Guillermo Soto nos ha golpeado bien golpeados esta noche. Ha descubierto una aplicación de Google lanzada este jueves 16 de diciembre de 2010 que consiste en el conjunto de listados de frecuencias de palabras más grande de la vida.

Guillermo Soto nos ha golpeado bien golpeados esta noche. Ha descubierto una aplicación de Google lanzada este jueves 16 de diciembre de 2010 que consiste en el conjunto de listados de frecuencias de palabras más grande de la vida.

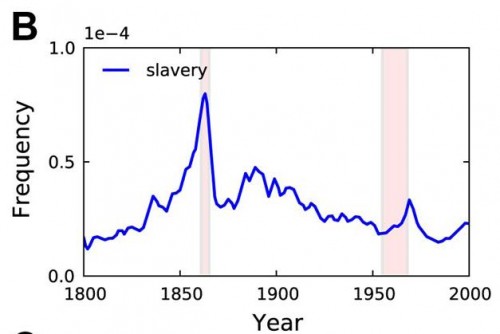

“Las bases de datos que estamos haciendo hoy disponibles para la investigación en humanidades se basan en un subconjunto de un corpus que contiene 500 mil millones de palabras en 5,2 millones de libros en chino, Inglés, francés, alemán, ruso y español. Los conjuntos de datos contienen frases de hasta cinco palabras con un recuento de la frecuencia con que ocurrieron en cada año. (…) El Visor de Ngram le permite graficar y comparar frases de estos conjuntos de datos a través del tiempo, mostrando cómo su uso ha sufrido altibajos en los últimos años” (Jon Orwant, Equipo de Google Books).

El visor está disponible en esta página: http://ngrams.googlelabs.com/ y permite modificar las fechas de análisis de los libros, el idioma en que se va a hacer el trabajo y el smoothing, que significa lo siguiente:

A menudo, las tendencias se hacen más evidentes cuando los datos se ven como una media móvil. Un suavizado de 1 significa que los datos mostrados para 1950 será un promedio de la cuenta prima para 1950 más 1 valor a cada variedad: (“cuenta para 1949” + “cuenta para 1950” + “cuenta para 1951”), dividido por 3. Así que una suavización de 10 significa que el 21 valores se promediará: 10 a cada lado, más el valor objetivo en el centro de ellos.

En los bordes izquierdo y derecho de la gráfica, menos valores se promedian. Con un suavizado de 3, el valor más a la izquierda (fingir que es el año 1950) se calcula como (“cuenta para 1950” + “cuenta para 1951” + “cuenta para 1952” + “cuenta para 1953”), dividido por 4.

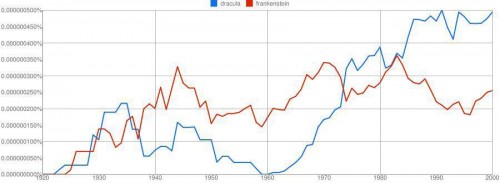

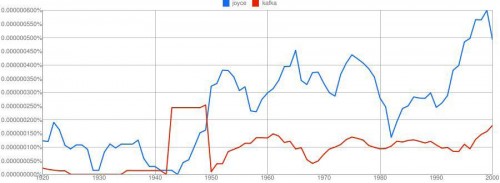

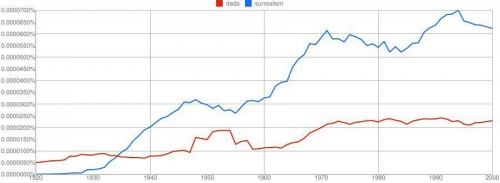

Algunos ejemplos de análisis que se nos han ocurrido:

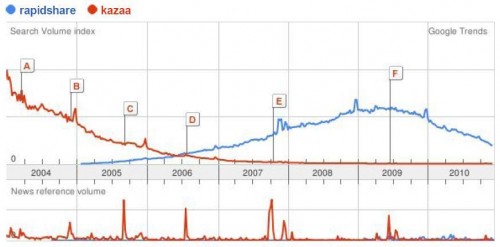

Esta aplicación parece ser incluso más poderosa para el análisis lingüístico y de tendencias culturales (de hecho, los investigadores ya bautizaron este Mamut como “culturomics“) que otra ya existente, Google Trends, que, de todas maneras nos permitía hacer descubrimientos como el siguiente:

Otro aspecto interesantísimo de Books Ngram Viewer es que tienen disponible vía CC todos sus listados, en ESTA DIRECCIÓN.

ACTUALIZACIÓN (5 de la madrugada del 17 de diciembre)

Le he dado una vuelta a este notición, y creo que es la noticia más importante para la lingüística (y para la lingüística computacional) de la historia (equivalente a la secuenciación del genoma humano). Un extraordiniario artículo del New York Times, tuiteado por Pinker y citado en los comentarios por Remis cita a Erez Lieberman, con dos quotes importantes:

“El objetivo es dar a un niño de 8 años de edad, la capacidad de ver las tendencias culturales a lo largo de la historia, según consta en los libros”.

“Queríamos mostrar lo que se hace posible cuando se aplica el análisis de datos en versión turbo a las preguntas en las humanidades”.

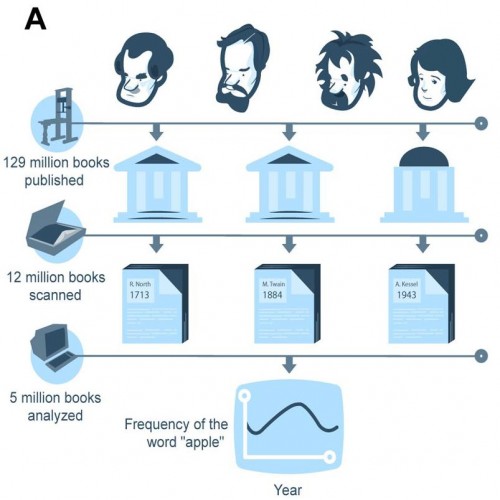

Solo una infografía para dimensionar la increíble magnitud del Corpus Google:

Según los autores, en el mundo se han publicado 129 millones de libros, de los cuales Google tiene escaneados 12 millones (casi un 10%) y para los listados de frecuencias se usaron 5 millones. UN 4% de todos los libros escritos en la historia: la verdadera Biblioteca de Alejandría.

El artículo original publicado hoy por Science (también referenciado por San Remis), indica con más precisión, que para el caso del Español, el corpus posee 45.000 millones de palabras (o sea, es unas 100 veces más grande que el CORDE o el CREA, hasta ahora, los corpus públicos más voluminosos en nuestra lengua), y unas cincuenta veces más grande que el CODICACH de Scott Sadowsky (huelga decir que el CODICACH contiene solo español de Chile, por lo que creo que la sección del Corpus Google dedicada a Chile, quizá todavía no supera el tamaño de aquel).

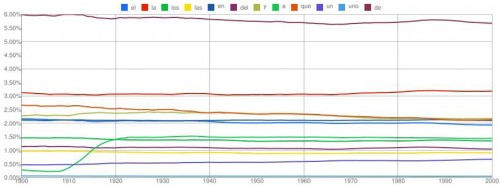

Para mostrarles solo un ejemplo (armado a las 6 de la mañana :-)) de qué cosas se pueden hacer con el Corpus Google, veamos la lista de las doce palabras más frecuentes del español (listado extraído del Lifcach -Sadowsky & Martínez 2002), el, la, los, las, en, del, y, a, que, un, uno, de, entre 1900 y 2000:

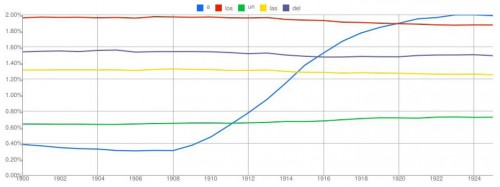

Como se puede observar, las líneas son casi planas, esto es, se mantienen a lo largo del siglo las palabras con su frecuencia relativa constante. EXCEPTO UNA: “a“. Por favor, miren el detalle (hacer click para agrandar).

“a” quintuplica su frecuencia, desde un 0,40% del total del corpus (esto es, aparece una vez cada 250 palabras) en 1900, hasta un 2,00% del total corpus (esto es, aparece una vez cada 50 palabras) hacia 1925. Obsérvese también que supera a “un” en 1911, supera a “las” en 1914, supera a “del” en 1915, y finalmente supera a “los” en 1920. Esto significa que la palabra “a” avanzó en solo siete años a inicios del siglo veinte desde el undécimo puesto en el ranking de frecuencia hasta el séptimo (cual tenista profesional, LOL). Ojo, puede esto deberse a que la “a” sea la letra, o el artículo en inglés, u otras opciones. Se debe revisar los n-gramas para más detalles.

Todo lo anterior es posible de realizar solo con el Books NGram Viewer, pero, hay más. Sigamos con algunos ejemplos tomados desde el NYT y desde el artículo original (que se puede descargar gratuitamente si uno se suscribe gratuitamente a Science):

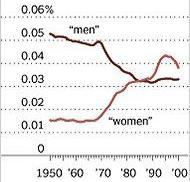

Lenguaje no sexista. En los años cincuenta, en los Estados Unidos, el uso de "men" quintuplicaba a "women", a mediados de los ochenta "women" sobrepasó a "men".

"Marilyn Monroe" ha crecido en apariciones en libros desde los años cincuenta hasta hoy. Pero, es superada desde mediados de los setentas por "Jimmy Carter".

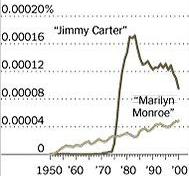

La palabra "slavery" (esclavitud) crece durante toda la primera mitad del siglo XIX, y tiene un peak para la Guerra Civil de los Estados Unidos, para luego decaer. Y vuelve a tener un peak en los sesentas durante la lucha por los derechos civiles.

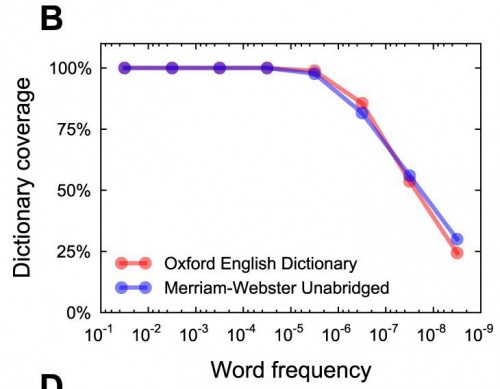

El término "Gran Guerra" (the Great War) aparece hacia 1914 y se mantiene constante hasta 1939, en que es reemplazada por la "Primera Guerra Mundial" (World War I).

Pero, no solo se trata de ver cómo evolucionan las palabras. Los autores hacen otras cosas, apoyados en un sistema de almacenaje que llega a doler de lo sencillo. Esta es la forma como se registra el corpus:

ngram TAB year TAB match_count TAB page_count TAB volume_count NEWLINE

En la primera columna aparece la palabra o el n-grama, luego el año documentado, luego cuántas ocurrencias tiene ese año, luego en cuántas páginas aparece y finalmente en cuántos libros aparece, tal como se puede ver acá:

circumvallate 1978 313 215 85 circumvallate 1979 183 147 77

La palabra “circunvallate” aparece en 1978 en 313 ocasiones, en 215 páginas diferentes y en 85 libros diferentes, y en 1979 aparece en 183 ocasiones, en 147 páginas diferentes y en 77 libros diferentes. Lo mismo se almacena para grupos de 2, 3, 4 y 5 palabras, para cada uno de los lenguajes incorporados (lamentablemente, para el español solo han subido para descarga los unigramas, bigramas y pentagramas; faltando los trigramas y tetragramas).

Veamos algunas cositas más:

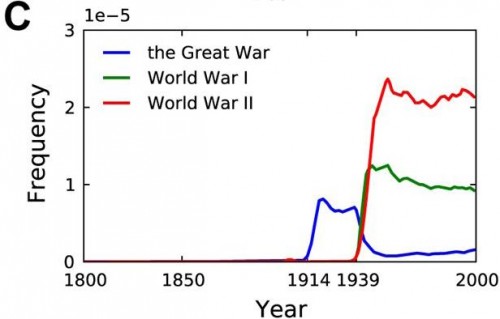

En este gráfico se muestra el total de palabras diferentes en el corpus en inglés a lo largo del siglo XX. Se inicia con un poco más de 500.000 en 1900 y se llega a alrededor de un millón en 2000 (ojo, esto puede depender del tamaño del corpus para cada año, mientras más grande el corpus más grande el número de palabras distintas -Ley de Heaps).

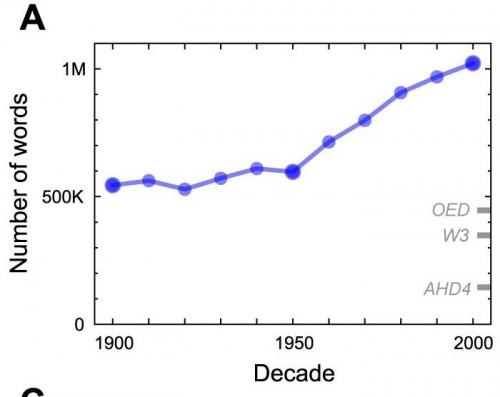

Este gráfico muestra la cobertura de los diccionarios Oxford English Dictionary y Merriam Webster, respecto de las palabras en cuanto a su frecuencia. A medida que disminuye la frecuencia de la palabra disminuye también la cobertura, llegando a solo cerca de un 25%.

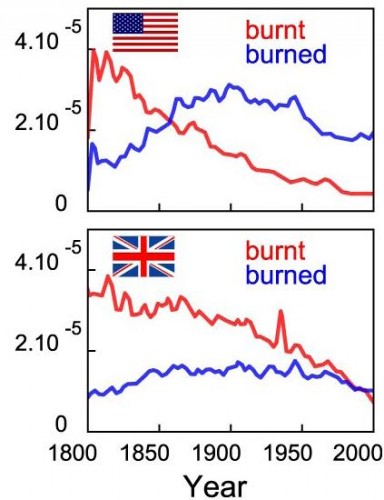

Un hallazgo de gramática histórica. En los Estados Unidos el irregular "burnt" fue reemplazado por "burned" hacia mediados del siglo XIX, en Inglaterra es algo que está ocurriendo hoy.

Dividimos una lista de 154 inventos en el tiempo en grupos con intervalos de cuarenta años en los que se inventaron (1.800 a 1840, 1840-1880, y 1880 – 1920). Seguimos la frecuencia de cada invención desde que se inventó hasta su valor máximo (…) Los inventos de la primera cohorte (1800-1840) necesitaron más de 66 años a partir de la invención para tener un amplio impacto (frecuencia> 25% del máximo). Desde entonces, la aprobación cultural de la tecnología se ha vuelto más rápida: para la cohorte 1840-1880 las invenciones fueron adoptadas ampliamente dentro de los 50 años siguientes, para la cohorte de 1880-1920 en solo 27.

Palabras al cierre

Cuando Víctor Herrero nos envió su aguda crítica a WikiLeaks (y el Corpus Google ES el WikiLeaks de los lingüistas) algo en ella no lograba convencerme del todo, y es que como alguien aficionado a la Lingüística Computacional, creo que los datos pesan mucho, sobre todo en la medida en que vamos teniendo mejores herramientas para hacerles minerías (de lo que son buenos ejemplos el Índice de Felicidad de Twitter y, humildemente, nuestro LUN Zeitgeist): el tamaño SÍ importa, y mucho. Sostengo, hoy más que nunca, en que los lingüistas hemos tenido nuestro día, que no estamos lejos de grandes hallazgos movilizados por los volúmenes masivos de información. Hoy entramos de lleno en el Cuarto Paradigma. Así que, Randall Munroe, piénsalo bien antes de repetir este chiste:

10 comments

Remis says:

Dic 17, 2010

Ojo con los links que posteó Pinker en su Twitter:

http://www.nytimes.com/2010/12/17/books/17words.html?_r=2&hp

http://www.sciencemag.org/content/early/2010/12/15/science.1199644

Recién ahora terminé de converncerme que el mission statement de Google es de veritas: “La misión de Google es organizar la información mundial para que resulte universalmente accesible y útil.” ^_^

Carlos Balboa says:

Dic 17, 2010

Muy interesante, le mandé el link al experto de análisis semántico latente en la PUCV. Una lástima que no esté “flaite”, le estoy siguiendo la pista porque no recuerdo haberla utilizado durante mi adolescencia y ahora aparece en todas partes.-

Valeria Mora says:

Ene 3, 2011

Me interesó eso sobre “falite”. Recuerdo que cuando era más pequeña mis tías y mi madre utilizaban “cuma” para designar lo que ahora denominamos “flaite”. Quizá pueda ser un dato de ayuda…Solo una idea 🙂

soledad Chávez Fajardo says:

Dic 17, 2010

Excelente: es una caja infinita de bombones (o de quesos, en mi caso) que se nos viene encima. ¡Gracias por compatir la noticia de forma tan pedagógica (como siempre, pues)!

Emiliano Navarrete says:

Dic 17, 2010

No entendí nada.

Lo leeré mas paciente.

Remis says:

Dic 18, 2010

Muy en resumen, y omitiendo los detalles escabrosos… esto es PORNO PARA LINGÜISTAS (e historiadores, sociólogos, etc). Lo que es lo mismo que decir “geeks”. xD

Valeria Mora says:

Ene 3, 2011

jajaaj notable resumen!

Cristian Darville says:

Dic 20, 2010

Como siempre Don Ricardo, a la vanguardia ud! Excelente nota…

un abrazo!

Tercera Cultura S05E01: VIDA 2.0, CIENCIA 3.0 | TerceraCultura.cl says:

Abr 4, 2011

[…] * Google Trends y Google nGram […]

miguel says:

Ene 16, 2012

Te pasaste Martínez. Gran post.