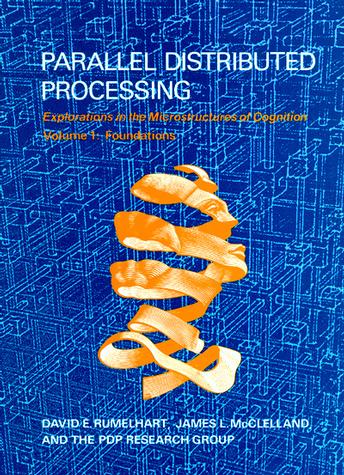

Replace the “computer metaphor” as a model of mind with the “brain metaphor” (Rumelhart & McClelland, 1986)

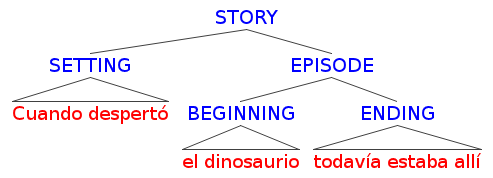

Hace algunos meses comentamos en nuestra cuenta de Twitter que para tristeza de la comunidad cognitiva había fallecido uno de sus founding fathers: David Rumelhart. Rumelhart estuvo en todas, y cada uno de los periodos de la ciencia cognitiva le debe algo. Cuando fue el día de los modelos formales de la CC Clásica, ahí se encontraba para levantar su propia formalización de la gramática de historias (Rumelhart, 1977; Rumelhart & Ortony, 1977), una versión de la Gramática Generativa extendida para dar cuenta de segmentos de texto más extensos que las oraciones.

Luego trabajó incansablemente en un campo desprestigiado, el de las redes neurales, a lo largo de toda la primera mitad de los ochenta, en lo que fue el inicio de la caída de las aproximaciones tradicionales a la cognición.

Luego trabajó incansablemente en un campo desprestigiado, el de las redes neurales, a lo largo de toda la primera mitad de los ochenta, en lo que fue el inicio de la caída de las aproximaciones tradicionales a la cognición.

“Dos tipos de dispositivos se sabe que pueden soportar funciones tales como la percepción, la memoria, el lenguaje y la solución de problemas. Uno de ellos es la computadora digital moderna, programada para producir “inteligencia artificial” (AI), y el otro es el cerebro humano, que produce la variedad natural. Dado que este último dispositivo parece más íntimamente ligado a la mente humana, puede parecer sorprendente que la metáfora dominante para el desarrollo de las teorías de los procesos mentales se haya basado en el otro” (Holyoak, 1987).

La historia ha sido bastante repetida, casi en paralelo con la idea de que la mente podía ser entendida como un computador que procesaba algoritmos o procedimientos matemáticos, en la primera mitad del siglo XX, otros grupos de investigadores se encaminaron pensando que no eran las rutinas el crack para desentrañar los misterios de la mente, sino que procesamientos individuales de unidades menores. Todo se inicia (al menos en la lectura mainstream) con el paper de McCulloch & Pitts (1943) y su propuesta de neuronas artificiales:

1. La actividad neuronal es un proceso “todo o nada”.

2. Un cierto número fijo de sinápsis debe ser excitado dentro de un período de adición latente en orden de excitar una neurona en cualquier intervalo de tiempo, y este número es independiente de la actividad previa y la posición de la neurona.

3. El único retardo significativo dentro del sistema es el retardo sináptico.

4. La actividad de cualquier sinápsis inhibitoria previene absolutamente la excitación de la neurona en ese intervalo de tiempo.

5. La estructura de la red no cambia con el tiempo.

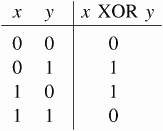

El asunto continúa con la aplicación de estas neuronas artificiales a la percepción (el Perceptrón de Rosenblatt de 1957). Hasta acá, bien. Las redes neurales pueden hacer cálculos lógicos, simular la percepción, etc. Lamentablemente, la empresa concluye abruptamente (en un episodio que para la ciencia cognitiva equivale a una cancelación de temporada) en 1969, cuando Minsky & Papert publican un libro sobre los perceptrones que muestra que ellos no pueden realizar ciertas operaciones lógicas (en particular el XOR, o Y excluyente, si p y q son verdaderos ambos, el valor de verdad es FALSO), lo que provoca uno de los Inviernos de la Inteligencia Artificial.

Por cerca de década y media, parece que todo está perdido para la aproximación neural a la cognición. Diversos investigadores siguen en secreto esa línea, casi sin apoyo de fondos. Y entonces, en 1986, David Rumelhart, James McClelland y el PDP Reseach Group publican dos volúmenes voluminosísimos sobre el tema: Parallel Distributed Processing.

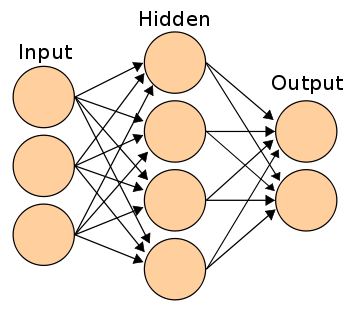

Las bases sobre las que se articula la arquitectura conexionista propuesta por ellos (llamada PDP, o redes neurales artificiales) son:

Las bases sobre las que se articula la arquitectura conexionista propuesta por ellos (llamada PDP, o redes neurales artificiales) son:

a) “el procesamiento [cognitivo] es realizado por un largo número de operadores en paralelo conforme a principios de similaridad y contigüidad” (Sloman 1999:125),

b) en este entendido no se posee “ni programas, ni un procesador central que controle su actividad” (MacCauley 1998:618), pero

c) “guarda cierta relación con la arquitectura y el trabajo del cerebro biológico” (Clark 2001:62).

Rumelhart and friends con ese mamotreto lo cubrieron casi todo, la cantidad de aportes notables de ese par de libros llegó a situarlos como la quinta obra más influyente de la historia de las Ciencias Cognitivas (en el Top 100). Entre los tópicos que se abordan están las redes de tres capas, las capas ocultas, el backpropagation, etc., etc.

Rumelhart and friends con ese mamotreto lo cubrieron casi todo, la cantidad de aportes notables de ese par de libros llegó a situarlos como la quinta obra más influyente de la historia de las Ciencias Cognitivas (en el Top 100). Entre los tópicos que se abordan están las redes de tres capas, las capas ocultas, el backpropagation, etc., etc.

A nosotros, en todo caso, el texto que más nos ha entusiasmado de dicha colección en todos estos años, es la versión conexionista de los esquemas, marcos y guiones (que, no por nada fueron el tema del Primer Episodio de nuestro Podcast); capítulo 14 (Schemata and Sequential Thought Processes in PDP Models).

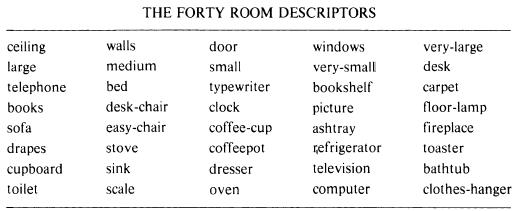

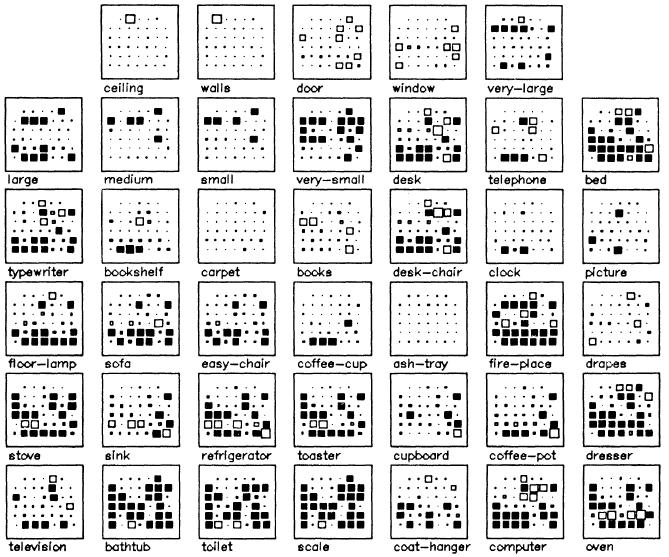

En simple, R&M levantaron una aplicación neural para el reconocimiento de esquemas de piezas (por ejemplo). Puntuaron diversos objetos comunes de habitaciones como baños, cocinas o livings o dormitorios, listados en el cuadro siguente.

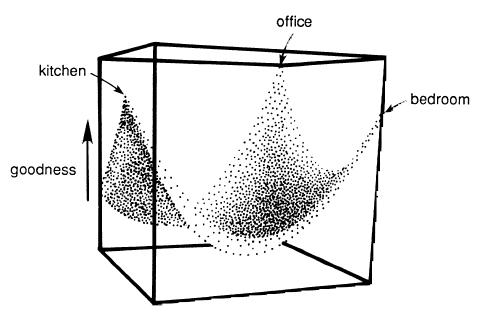

Y luego echaron a correr la red, para determinar cómo se distribuían dichos elementos como características o propiedades de las piezas.

Y luego echaron a correr la red, para determinar cómo se distribuían dichos elementos como características o propiedades de las piezas.

La red podía determinar, solo por coocurrencias de elementos, con qué pieza se “encontraba”.

La red podía determinar, solo por coocurrencias de elementos, con qué pieza se “encontraba”.

Como bien reseñara Keith Holyoak hace ya un cuarto de siglo:

Como bien reseñara Keith Holyoak hace ya un cuarto de siglo:

“El mayor valor del libro es que la propuesta establece claramente un paradigma y lo aplica a ejemplos concretos e interesantes. El libro abre una puerta que los científicos cognitivos pueden entrar: algunos se quedarán y se unirán al movimiento, otros se robarán unas cuantas ideas y se irán, y otros aún aprenderán por qué prefieren quedarse fuera. Todos querrán echar un vistazo”.

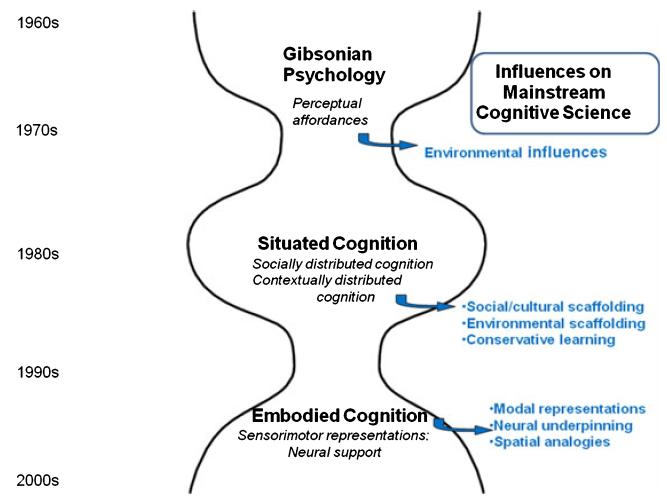

Muchos ingresaron por esa puerta, y muchos más abrieron a partir de ella otras puertas más. Un dibujito lo ilustra mejor que nada, el histograma que realizó Dedre Gentner para TOPICS el año pasado, que muestra las influencias de los modelos alternativos sobre las CC.